Trong môi trường SEO cạnh tranh cao, việc hiểu rõ và tuân thủ các chính sách của Google là điều kiện tiên quyết để đảm bảo sự ổn định và tăng trưởng thứ hạng. Tuy nhiên, nhiều doanh nghiệp và SEOer vẫn còn bỡ ngỡ khi đối mặt với các vi phạm chính sách spam. Bài viết này, V4SEO sẽ đi sâu phân tích chính sách spam Google là gì, cách các chính sách này tác động đến hiệu suất SEO kỹ thuật, đồng thời cung cấp các hướng dẫn kỹ thuật chi tiết để phát hiện, khắc phục và phòng ngừa các vi phạm. Mục tiêu của chúng tôi là trang bị cho bạn kiến thức chuyên sâu để bảo vệ website khỏi các hình phạt không đáng có, duy trì sự hiện diện bền vững trên công cụ tìm kiếm.

Chính sách spam của Google là gì và tại sao chúng lại quan trọng cho SEO kỹ thuật?

Google đặt ra các chính sách spam để đảm bảo chất lượng và tính phù hợp của kết quả tìm kiếm, mang lại trải nghiệm tốt nhất cho người dùng. Việc hiểu rõ các chính sách này là vô cùng quan trọng, không chỉ với SEO tổng thể mà đặc biệt là với SEO kỹ thuật, nơi các sai phạm có thể ẩn sâu trong cấu trúc website và mã nguồn.

Định nghĩa cốt lõi: Nội dung rác và mục đích của Google

Chính sách spam của Google là tập hợp các nguyên tắc và hướng dẫn do Google ban hành, nhằm ngăn chặn các hành vi thao túng kết quả tìm kiếm một cách giả tạo, đồng thời đảm bảo các website hiển thị trên SERP cung cấp nội dung có giá trị, hữu ích và liên quan cho người dùng. Bất kỳ nội dung hoặc kỹ thuật nào được thiết kế chủ yếu để thao túng thứ hạng tìm kiếm thay vì phục vụ người dùng đều được xem là nội dung rác.

Tác động sâu rộng của vi phạm chính sách spam: Từ thứ hạng đến trải nghiệm người dùng

Vi phạm chính sách spam có thể gây ra những hậu quả nghiêm trọng, từ việc giảm sút thứ hạng, tụt traffic organic, cho đến việc bị xóa hoàn toàn khỏi chỉ mục tìm kiếm của Google. Các hình phạt này không chỉ ảnh hưởng trực tiếp đến doanh thu và khả năng tiếp cận khách hàng tiềm năng mà còn làm suy yếu uy tín thương hiệu. Hơn nữa, những website có dấu hiệu spam thường mang lại trải nghiệm người dùng kém, làm tăng tỷ lệ thoát (bounce rate) và giảm thời gian trên trang (time on site), từ đó gián tiếp ảnh hưởng xấu đến các tín hiệu xếp hạng khác.

Cập nhật mới nhất về chính sách spam và thuật toán (SpamBrain, Core Updates)

Google liên tục cập nhật các chính sách và thuật toán của mình để chống lại spam một cách hiệu quả hơn. Các thuật toán như SpamBrain sử dụng trí tuệ nhân tạo để chủ động phát hiện và vô hiệu hóa các hành vi spam mới nổi. Bên cạnh đó, các bản cập nhật thuật toán cốt lõi (Core Updates) thường xuyên tái đánh giá chất lượng tổng thể của website, bao gồm cả việc tuân thủ các chính sách spam. Điều này đòi hỏi các chuyên gia SEO phải liên tục cập nhật kiến thức, không ngừng phân tích intent chính của người dùng và điều chỉnh chiến lược để luôn phù hợp với các tiêu chuẩn của Google.

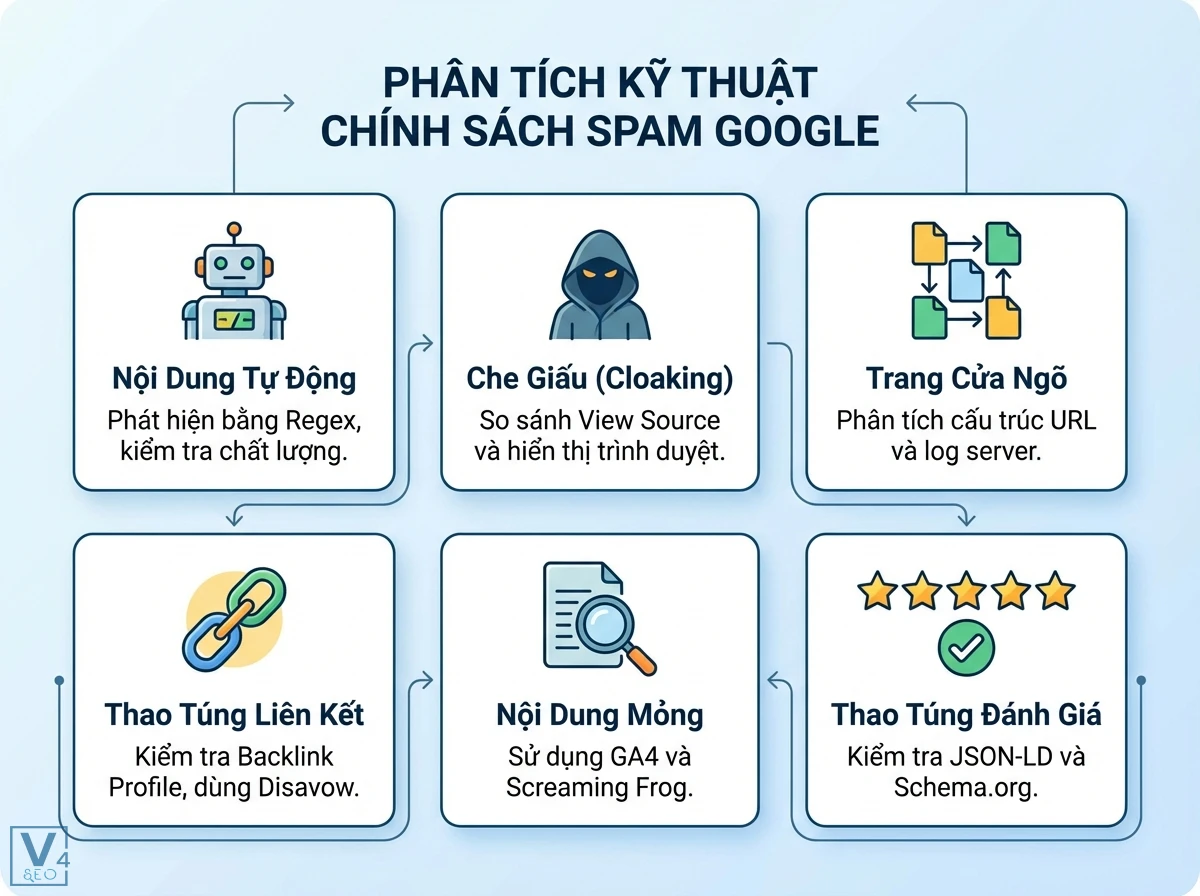

Phân tích chuyên sâu các chính sách spam của Google và cách nhận diện kỹ thuật

Để chủ động phòng chống và khắc phục, việc hiểu rõ từng loại chính sách spam cùng các dấu hiệu nhận diện kỹ thuật là điều thiết yếu.

Nội dung rác tự động tạo (Automatically generated content): Phát hiện bằng Regex và kiểm tra chất lượng

Nội dung tự động tạo là những bài viết được sản xuất hàng loạt bằng phần mềm hoặc AI mà không có sự kiểm duyệt, biên tập của con người, thường có chất lượng thấp và không mang lại giá trị thực.

Dấu hiệu nhận biết kỹ thuật:

- Mẫu câu lặp đi lặp lại hoặc cú pháp bất thường.

- Thiếu tính mạch lạc, logic trong nội dung.

- Sử dụng quá nhiều từ khóa nhưng không tự nhiên.

- Thường xuyên xuất hiện trên các website có hàng ngàn trang mới được tạo ra nhanh chóng.

Phát hiện bằng Regex:

Có thể sử dụng Regex để tìm các mẫu câu, cấu trúc HTML lặp lại bất thường trong mã nguồn của nhiều trang, hoặc các cụm từ thể hiện tính “tự động” như “bài viết này được tạo tự động”.

/(tự động tạo|được tạo bởi AI|content auto generate)/gi

Che giấu (Cloaking): Cách kiểm tra mã nguồn (HTML, CSS, JS) và phản ứng với Googlebot

Cloaking là kỹ thuật hiển thị nội dung khác nhau cho người dùng và các công cụ tìm kiếm (như Googlebot), nhằm thao túng thứ hạng.

Dấu hiệu nhận biết kỹ thuật:

- Nội dung hiển thị trên trình duyệt và nội dung trong mã nguồn (view-source) khác nhau đáng kể.

- Sử dụng JavaScript hoặc CSS để ẩn nội dung, liên kết chỉ hiển thị cho người dùng.

- Phản hồi server khác nhau tùy thuộc vào User-Agent (người dùng hay Googlebot).

Cách kiểm tra:

- Sử dụng công cụ “Kiểm tra URL” trong Google Search Console để xem trang được Googlebot render như thế nào.

- So sánh nội dung hiển thị trong trình duyệt với kết quả từ các công cụ như “View Source” hoặc cURL với User-Agent của Googlebot.

- Kiểm tra các tệp CSS, JavaScript để tìm các lệnh display: none;, visibility: hidden; được áp dụng cho nội dung quan trọng mà không vì mục đích trải nghiệm người dùng hợp lý.

Trang cửa ngõ (Doorway pages): Phát hiện qua phân tích cấu trúc URL, log server với SQL

Trang cửa ngõ là các trang được tạo ra với mục đích duy nhất là xếp hạng cho các cụm từ khóa cụ thể, sau đó chuyển hướng người dùng đến một trang khác.

Dấu hiệu nhận biết kỹ thuật:

- Nhiều trang có nội dung gần như giống hệt nhau hoặc rất mỏng, chỉ khác biệt về từ khóa mục tiêu hoặc vị trí địa lý.

- Các trang này thường có cấu trúc URL tương tự nhau, được tạo hàng loạt.

- Chuyển hướng người dùng tự động (meta refresh, JavaScript redirect) hoặc thông qua liên kết mồi nhử.

Phân tích log server với BigQuery/SQL:

Truy vấn log server để tìm các trang nhận nhiều truy cập từ bot nhưng có tỷ lệ thoát cao và thời gian ở lại trang cực thấp từ người dùng, kèm theo các chuyển hướng sau đó.

SELECT

request_url,

COUNT(DISTINCT ip_address) AS bot_hits,

AVG(response_time) AS avg_response_time,

COUNTIF(status_code >= 300 AND status_code < 400) AS redirect_count

FROM

`your_project.your_dataset.server_logs`

WHERE

user_agent LIKE ‘%Googlebot%’

GROUP BY

request_url

HAVING

redirect_count > 0 AND bot_hits > 100

ORDER BY

redirect_count DESC;

Nội dung bị hack và lừa đảo (Hacked content & Scams): Dấu hiệu trong GSC và các công cụ bảo mật

Nội dung bị hack là khi tin tặc chèn nội dung rác hoặc mã độc vào website của bạn. Scams là các trang lừa đảo người dùng.

Dấu hiệu nhận biết kỹ thuật:

- Website đột nhiên xuất hiện các trang, liên kết, hoặc nội dung không liên quan (ví dụ: dược phẩm, cờ bạc).

- Google Search Console báo cáo “Vấn đề bảo mật” (Security Issues).

- Các file lạ xuất hiện trên server.

- Chuyển hướng độc hại (malicious redirects).

Sử dụng GSC: Thường xuyên kiểm tra báo cáo “Vấn đề bảo mật” trong Google Search Console.

Thao túng liên kết (Link spam): Phân tích backlink profile, sử dụng công cụ Disavow, thuộc tính rel=’sponsored/ugc’

Link spam là bất kỳ nỗ lực nào nhằm thao túng PageRank hoặc thứ hạng của một trang web trong kết quả tìm kiếm của Google thông qua các liên kết không tự nhiên.

Dấu hiệu nhận biết kỹ thuật:

- Số lượng backlink tăng đột biến từ các website kém chất lượng, không liên quan.

- Các anchor text trùng lặp một cách bất thường.

- Mua bán liên kết (paid links) mà không sử dụng thuộc tính rel=”sponsored”.

- Liên kết trong các bình luận hoặc diễn đàn mà không có rel=”ugc” hoặc rel=”nofollow”.

Cách khắc phục:

- Kiểm tra backlink profile bằng các công cụ như Ahrefs, Semrush.

- Sử dụng công cụ Disavow của Google để từ chối các backlink độc hại.

- Đảm bảo các liên kết trả phí hoặc liên kết do người dùng tạo có thuộc tính rel=”sponsored” hoặc rel=”ugc” tương ứng.

Nội dung kém chất lượng/sao chép (Scraped/Thin content): Sử dụng GA4 và Screaming Frog để đánh giá quy mô

Nội dung sao chép hoặc mỏng là nội dung được lấy từ website khác mà không thêm giá trị, hoặc nội dung quá ít thông tin, không hữu ích cho người dùng.

Dấu hiệu nhận biết kỹ thuật:

- Tỷ lệ nội dung trùng lặp cao (kiểm tra bằng Copyscape hoặc các công cụ tương tự).

- Các trang có ít hơn 200-300 từ mà không có mục đích rõ ràng (ví dụ: trang danh mục sản phẩm có mô tả quá ngắn).

- Trong GA4, các trang có thời gian ở lại trang rất thấp và tỷ lệ thoát cao.

Cách đánh giá quy mô:

- Screaming Frog: Crawl website, lọc các trang có từ count thấp.

- GA4: Tạo báo cáo tùy chỉnh để theo dõi các trang có session_duration thấp hoặc bounce_rate cao bất thường cho lưu lượng truy cập organic.

Nhồi nhét từ khóa (Keyword stuffing): Dùng Regex để xác định mật độ từ khóa bất thường

Nhồi nhét từ khóa là việc lặp đi lặp lại một từ khóa hoặc cụm từ khóa một cách không tự nhiên nhằm mục đích thao túng thứ hạng.

Dấu hiệu nhận biết kỹ thuật:

- Mật độ từ khóa quá cao (>3-5%) mà không tự nhiên.

- Các cụm từ khóa được liệt kê trong một danh sách mà không có ngữ cảnh.

- Sử dụng biến thể từ khóa không liên quan.

Phát hiện bằng Regex:

Sử dụng Regex để đếm số lần xuất hiện của một từ khóa trong nội dung và tính toán mật độ.

/(từ khóa chính sách spam Google|chính sách spam Google là gì){5,}/gi

(Ví dụ: Tìm kiếm 5 lần xuất hiện trở lên của cụm từ trong một đoạn văn ngắn)

Văn bản/Liên kết ẩn (Hidden text/links): Kiểm tra thông qua mã CSS, JavaScript và công cụ kiểm tra của trình duyệt

Văn bản hoặc liên kết ẩn là nội dung được che giấu khỏi người dùng nhưng có thể được Googlebot nhìn thấy, thường nhằm mục đích nhồi nhét từ khóa hoặc tạo liên kết không tự nhiên.

Dấu hiệu nhận biết kỹ thuật:

- Sử dụng display: none;, visibility: hidden; trong CSS.

- Sử dụng màu văn bản trùng với màu nền.

- Đặt kích thước font chữ rất nhỏ (0px) hoặc ngoài màn hình.

- Sử dụng JavaScript để thay đổi DOM và ẩn nội dung.

Cách kiểm tra:

- Sử dụng công cụ “Inspect Element” của trình duyệt để kiểm tra các thuộc tính CSS và JavaScript.

- Xem mã nguồn trang (View Source) và so sánh với nội dung hiển thị.

Thao túng đánh giá (Review manipulation): Hiểu đúng Schema.org và kiểm tra JSON-LD

Thao túng đánh giá là hành vi tạo ra các đánh giá giả mạo hoặc sai lệch để cải thiện điểm xếp hạng sản phẩm/dịch vụ, thường thông qua Structured Data.

Dấu hiệu nhận biết kỹ thuật:

- Schema.org đánh giá (Rating/Review Schema) được triển khai trên các trang không phù hợp (ví dụ: trang liên hệ, trang giới thiệu).

- Điểm đánh giá luôn cao bất thường mà không có đủ đánh giá thực tế từ người dùng.

- Dữ liệu đánh giá trong JSON-LD không khớp với nội dung hiển thị trên trang.

Kiểm tra JSON-LD:

Sử dụng công cụ Rich Results Test của Google để kiểm tra tính hợp lệ của Structured Data. Kiểm tra mã JSON-LD để đảm bảo các giá trị ratingValue, reviewCount phản ánh đúng nội dung trên trang.

Ví dụ JSON-LD sai:

{

“@context”: “https://schema.org/”,

“@type”: “Product”,

“name”: “Sản phẩm XYZ”,

“aggregateRating”: {

“@type”: “AggregateRating”,

“ratingValue”: “4.9”,

“reviewCount”: “1000”

}

}

(Nếu trên trang thực tế chỉ có 5 đánh giá và điểm trung bình là 3.5, đây là thao túng).

Các chính sách khác: Nội dung bản quyền, spam do người dùng tạo (UGC spam)

Google cũng có các chính sách liên quan đến nội dung bản quyền (DMCA) và spam do người dùng tạo (User-Generated Content spam), thường thấy trong phần bình luận, diễn đàn. Để tối ưu trải nghiệm đọc và tuân thủ, cần có hệ thống kiểm duyệt mạnh mẽ.

Hướng dẫn kỹ thuật chi tiết: Phát hiện, khắc phục và phục hồi từ hình phạt spam

Việc phát hiện và khắc phục các vi phạm chính sách spam đòi hỏi một quy trình kỹ thuật bài bản và sử dụng thành thạo các công cụ chuyên dụng.

Sử dụng Google Search Console như một chuyên gia: Các báo cáo và công cụ trọng yếu

Google Search Console (GSC) là công cụ quan trọng nhất để theo dõi hiệu suất website và phát hiện các vấn đề spam.

Cách sử dụng hiệu quả:

- Báo cáo “Hành động thủ công” (Manual Actions): Đây là nơi Google sẽ thông báo nếu website của bạn bị áp dụng hình phạt thủ công. Luôn kiểm tra báo cáo này thường xuyên.

- Báo cáo “Vấn đề bảo mật” (Security Issues): Cảnh báo về nội dung bị hack hoặc mã độc trên website.

- Công cụ “Kiểm tra URL” (URL Inspection Tool): Giúp bạn xem Googlebot nhìn và render một trang cụ thể như thế nào, phát hiện cloaking, nội dung ẩn.

- Báo cáo “Chỉ mục” (Indexing): Theo dõi số lượng trang được lập chỉ mục. Sự sụt giảm đột ngột có thể là dấu hiệu của hình phạt spam trên diện rộng.

- Báo cáo “Core Web Vitals”: Mặc dù không trực tiếp về spam, nhưng một website bị spam thường có hiệu suất Core Web Vitals kém, ảnh hưởng gián tiếp đến trải nghiệm người dùng.

Phân tích log server với BigQuery/SQL để xác định hành vi bot bất thường và spam trên diện rộng

Phân tích log server cung cấp cái nhìn sâu sắc về cách Googlebot và các bot khác tương tác với website, giúp phát hiện các mẫu truy cập bất thường liên quan đến spam.

Mẫu truy vấn SQL trong BigQuery:

1. Phát hiện cloaking hoặc doorway pages dựa trên User-Agent:

SELECT

request_url,

COUNT(DISTINCT IF(user_agent LIKE ‘%Googlebot%’, ip_address, NULL)) AS googlebot_hits,

COUNT(DISTINCT IF(user_agent NOT LIKE ‘%Googlebot%’ AND user_agent NOT LIKE ‘%bot%’, ip_address, NULL)) AS human_hits,

SUM(bytes_sent) AS total_bytes_sent

FROM

`project.dataset.access_logs`

WHERE

PARSE_DATE(‘%d/%b/%Y’, SUBSTR(timestamp, 2, 11)) >= ‘2024-01-01’

GROUP BY

request_url

HAVING

googlebot_hits > human_hits * 5 — Googlebot hits significantly more than human hits (heuristic)

ORDER BY

googlebot_hits DESC;

(Truy vấn này tìm các URL mà Googlebot truy cập nhiều hơn đáng kể so với người dùng thông thường, có thể là dấu hiệu của cloaking hoặc doorway pages được tối ưu riêng cho bot).

2. Xác định các URL bị chuyển hướng bất thường:

SELECT

request_url,

COUNT(*) AS redirect_count,

ARRAY_AGG(DISTINCT status_code) AS status_codes,

ARRAY_AGG(DISTINCT referer) AS referers

FROM

`project.dataset.access_logs`

WHERE

status_code BETWEEN 300 AND 399

GROUP BY

request_url

HAVING

redirect_count > 100 AND COUNT(DISTINCT referer) > 10 — Nhiều chuyển hướng từ nhiều nguồn khác nhau

ORDER BY

redirect_count DESC;

(Truy vấn này giúp phát hiện các URL bị chuyển hướng hàng loạt, thường là dấu hiệu của doorway pages hoặc các vấn đề bảo mật).

Tích hợp GA4 và GTM để giám sát các chỉ số liên quan đến spam (traffic bot, giảm lưu lượng organic đột ngột)

Google Analytics 4 (GA4) kết hợp với Google Tag Manager (GTM) cho phép giám sát sâu hơn các hành vi người dùng và lưu lượng truy cập, từ đó phát hiện các bất thường.

Các bước thực hiện:

1. Giám sát lưu lượng truy cập bot:

- Trong GA4: Sử dụng báo cáo “Traffic acquisition” và phân tích các nguồn traffic. Tìm kiếm các nguồn traffic lạ, tỷ lệ thoát cao, thời gian phiên thấp bất thường.

- Trong GTM: Triển khai các thẻ tùy chỉnh để phát hiện và lọc lưu lượng truy cập bot dựa trên User-Agent, địa chỉ IP hoặc các hành vi bất thường (ví dụ: truy cập quá nhanh, không có tương tác). Tạo sự kiện tùy chỉnh cho “bot_traffic” và đẩy vào GA4.

2. Phát hiện giảm lưu lượng organic đột ngột:

- Trong GA4: Thiết lập cảnh báo tùy chỉnh (Custom Alerts) cho “Organic Search traffic” nếu có sự giảm sút lớn hơn X% trong một khoảng thời gian nhất định (ví dụ: giảm 20% trong 7 ngày).

- Phân tích báo cáo “Explorations”: Tạo các báo cáo khám phá để so sánh lưu lượng organic trước và sau khi nghi ngờ bị phạt. Tập trung vào “User engagement” và “Bounce rate” cho các trang bị ảnh hưởng.

Các bước khắc phục cụ thể cho từng loại spam: Từ gỡ bỏ mã độc đến chỉnh sửa cấu trúc dữ liệu

| Lỗi | Dấu hiệu | Nguyên nhân | Cách khắc phục | Mức độ ưu tiên |

| Nội dung tự động tạo | Văn phong lủng củng, lặp từ, thiếu mạch lạc | Sử dụng AI/phần mềm không kiểm soát, dịch máy thô sơ | Gỡ bỏ hoặc viết lại thủ công toàn bộ nội dung. Tăng cường kiểm duyệt nội dung. | Cao |

| Che giấu (Cloaking) | Nội dung/liên kết khác nhau giữa người dùng và Googlebot | Cố ý thao túng hiển thị để lừa công cụ tìm kiếm | Đảm bảo nội dung hiển thị cho người dùng và Googlebot là giống nhau. Gỡ bỏ mọi đoạn mã CSS/JS ẩn. | Rất cao |

| Trang cửa ngõ (Doorway Pages) | Nhiều trang tương tự, chuyển hướng ngay lập tức | Tạo hàng loạt trang để bắt các từ khóa hẹp rồi điều hướng | Gỡ bỏ các trang cửa ngõ. Tập trung tối ưu hóa các trang đích chất lượng cao. | Rất cao |

| Nội dung bị hack/lừa đảo | Xuất hiện nội dung lạ, báo cáo GSC về bảo mật | Website bị tấn công bởi tin tặc | Xóa mã độc, khôi phục từ bản sao lưu sạch. Thay đổi mật khẩu mạnh, cập nhật CMS/plugin. Báo cáo lên GSC. | Rất cao |

| Thao túng liên kết (Link Spam) | Backlink profile kém chất lượng, anchor text lặp lại | Mua bán liên kết, trao đổi liên kết quá đà, spam bình luận | Gỡ bỏ/yêu cầu gỡ bỏ liên kết. Sử dụng công cụ Disavow trong GSC. Đảm bảo thuộc tính rel đúng (sponsored/ugc/nofollow). | Cao |

| Nội dung kém chất lượng/sao chép | Từ count thấp, trùng lặp cao, không có giá trị | Sao chép từ nguồn khác, tạo nội dung chỉ để có trang | Viết lại nội dung độc đáo, bổ sung giá trị. Hợp nhất hoặc gỡ bỏ các trang “mỏng”. | Trung bình |

| Nhồi nhét từ khóa (Keyword Stuffing) | Mật độ từ khóa cao bất thường, từ khóa lặp lại không tự nhiên | Cố gắng ép từ khóa để xếp hạng | Viết lại nội dung một cách tự nhiên, tập trung vào ngữ nghĩa và trải nghiệm người dùng. Sử dụng từ khóa đồng nghĩa và LSI. | Trung bình |

| Văn bản/Liên kết ẩn | Nội dung không thấy trên trình duyệt nhưng có trong mã nguồn | Cố ý che giấu thông tin khỏi người dùng | Xóa bỏ hoặc hiển thị công khai nội dung/liên kết. Nếu cần ẩn vì thiết kế, sử dụng các phương pháp được Google chấp nhận (ví dụ: toggle). | Cao |

| Thao túng đánh giá (Review Manipulation) | Structured Data sai lệch, đánh giá giả mạo | Cố gắng làm đẹp điểm số bằng cách gian lận | Sửa lại Structured Data cho chính xác, đảm bảo đánh giá phản ánh đúng thực tế trên trang. Loại bỏ đánh giá giả mạo. | Trung bình |

Quy trình yêu cầu xem xét lại (Reconsideration Request) sau khi khắc phục

Sau khi đã khắc phục triệt để các vấn đề spam, bạn cần gửi yêu cầu xem xét lại (Reconsideration Request) thông qua Google Search Console nếu website của bạn bị áp dụng hình phạt thủ công.

Các bước thực hiện:

Bước 1: Đảm bảo tất cả các vi phạm đã được xử lý một cách toàn diện. Cung cấp bằng chứng cụ thể về các hành động đã thực hiện (ví dụ: danh sách các URL đã xóa, mã nguồn đã sửa).

Bước 2: Truy cập báo cáo “Hành động thủ công” trong GSC.

Bước 3: Nhấp vào nút “Yêu cầu xem xét lại” (Request a review).

Bước 4: Viết một lá thư giải thích rõ ràng, ngắn gọn và trung thực về vấn đề bạn đã gặp, các bước bạn đã thực hiện để khắc phục, và cam kết không tái phạm. Cung cấp các đường dẫn URL làm ví dụ về các trang đã được sửa.

Bước 5: Gửi yêu cầu và kiên nhẫn chờ đợi phản hồi từ Google. Quá trình này có thể mất vài ngày đến vài tuần.

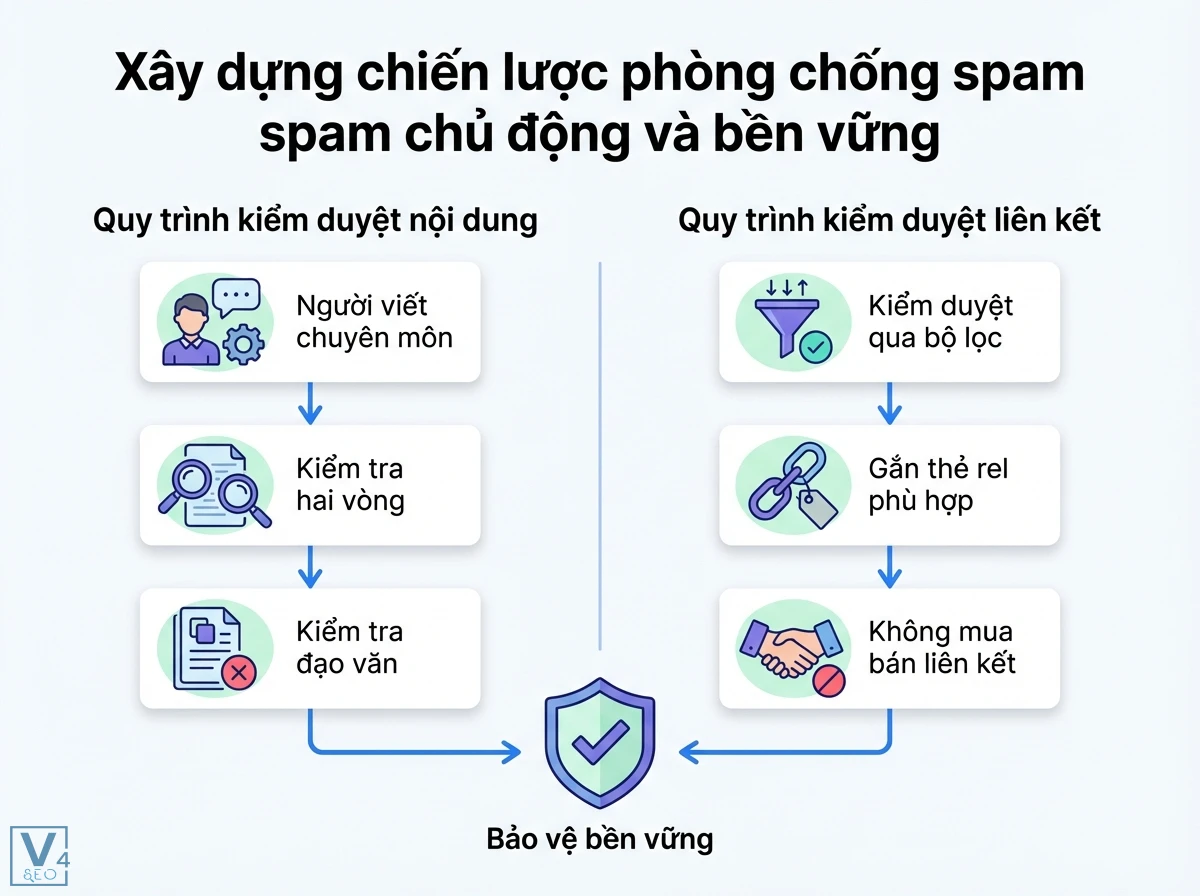

Xây dựng chiến lược phòng chống spam chủ động và bền vững

Việc phòng chống spam không chỉ là phản ứng mà còn là một chiến lược chủ động, đòi hỏi sự giám sát liên tục và quy trình chặt chẽ.

Checklist kiểm toán nội dung và kỹ thuật định kỳ để phát hiện sớm rủi ro

Việc thực hiện kiểm toán định kỳ giúp phát hiện sớm các dấu hiệu spam trước khi chúng gây ra hình phạt.

| Hạng mục | Chi tiết thực hiện | Mức độ ưu tiên |

| Kiểm tra GSC hàng tuần | Theo dõi báo cáo “Hành động thủ công”, “Vấn đề bảo mật”, “Chỉ mục” | Rất cao |

| Phân tích backlink profile hàng tháng | Sử dụng Ahrefs/Semrush để phát hiện liên kết xấu, liên kết tăng đột biến | Cao |

| Kiểm tra mật độ từ khóa | Sử dụng các công cụ SEO để kiểm tra các trang quan trọng có dấu hiệu nhồi nhét | Trung bình |

| Đánh giá chất lượng nội dung | Kiểm tra nội dung trùng lặp, nội dung mỏng, nội dung tự động tạo | Cao |

| Kiểm tra Structured Data | Sử dụng công cụ Rich Results Test để xác minh tính hợp lệ của Schema | Trung bình |

| Rà soát mã nguồn | Kiểm tra các đoạn mã CSS/JS ẩn, các thẻ meta refresh hoặc chuyển hướng lạ | Cao |

| Phân tích log server | Tìm kiếm hành vi bot bất thường, truy cập các trang lạ, chuyển hướng | Cao |

| Giám sát GA4 | Theo dõi lưu lượng truy cập organic, tỷ lệ thoát, thời gian trên trang cho các bất thường | Trung bình |

Thiết lập quy trình kiểm duyệt nội dung và liên kết chặt chẽ

Để ngăn chặn spam, cần có một quy trình kiểm duyệt rõ ràng cho mọi nội dung và liên kết được tạo ra hoặc trỏ đến website.

Quy trình kiểm duyệt nội dung:

Bước 1: Mọi nội dung mới phải được viết bởi người thật, có kiến thức chuyên môn.

Bước 2: Nội dung phải trải qua ít nhất hai vòng kiểm tra: kiểm tra chất lượng (ngữ pháp, chính tả, độ sâu thông tin) và kiểm tra SEO (không nhồi nhét từ khóa, không trùng lặp).

Bước 3: Sử dụng các công cụ như Copyscape để kiểm tra đạo văn trước khi xuất bản.

Quy trình kiểm duyệt liên kết (cho nội dung do người dùng tạo hoặc liên kết đi):

Bước 1: Mọi bình luận, bài viết diễn đàn, hoặc nội dung có liên kết do người dùng tạo phải được kiểm duyệt thủ công hoặc tự động qua các bộ lọc thông minh.

Bước 2: Đảm bảo các liên kết đi (outbound links) đều có thuộc tính rel phù hợp (nofollow, sponsored, ugc) tùy theo bản chất của liên kết.

Bước 3: Không mua bán liên kết hoặc tham gia vào các mạng lưới liên kết.

Duy trì và nâng cao E-E-A-T để xây dựng sự tin cậy

Google ngày càng chú trọng đến E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness – Kinh nghiệm, Chuyên môn, Thẩm quyền, Độ tin cậy) như một yếu tố quan trọng để đánh giá chất lượng website.

Cách nâng cao E-E-A-T:

1. Kinh nghiệm (Experience): Đảm bảo nội dung được viết bởi những người có kinh nghiệm thực tế về chủ đề, có thể chia sẻ góc nhìn độc đáo hoặc trải nghiệm cá nhân.

2. Chuyên môn (Expertise): Công bố tên tác giả rõ ràng, bao gồm thông tin về trình độ, bằng cấp, kinh nghiệm của họ.

3. Thẩm quyền (Authoritativeness): Xây dựng các liên kết chất lượng từ các website có uy tín trong ngành. Thường xuyên được các chuyên gia khác hoặc báo chí trích dẫn.

4. Độ tin cậy (Trustworthiness): Cung cấp thông tin chính xác, minh bạch. Đảm bảo website có các trang về chính sách bảo mật, điều khoản dịch vụ, thông tin liên hệ rõ ràng. Có chứng chỉ SSL (HTTPS).

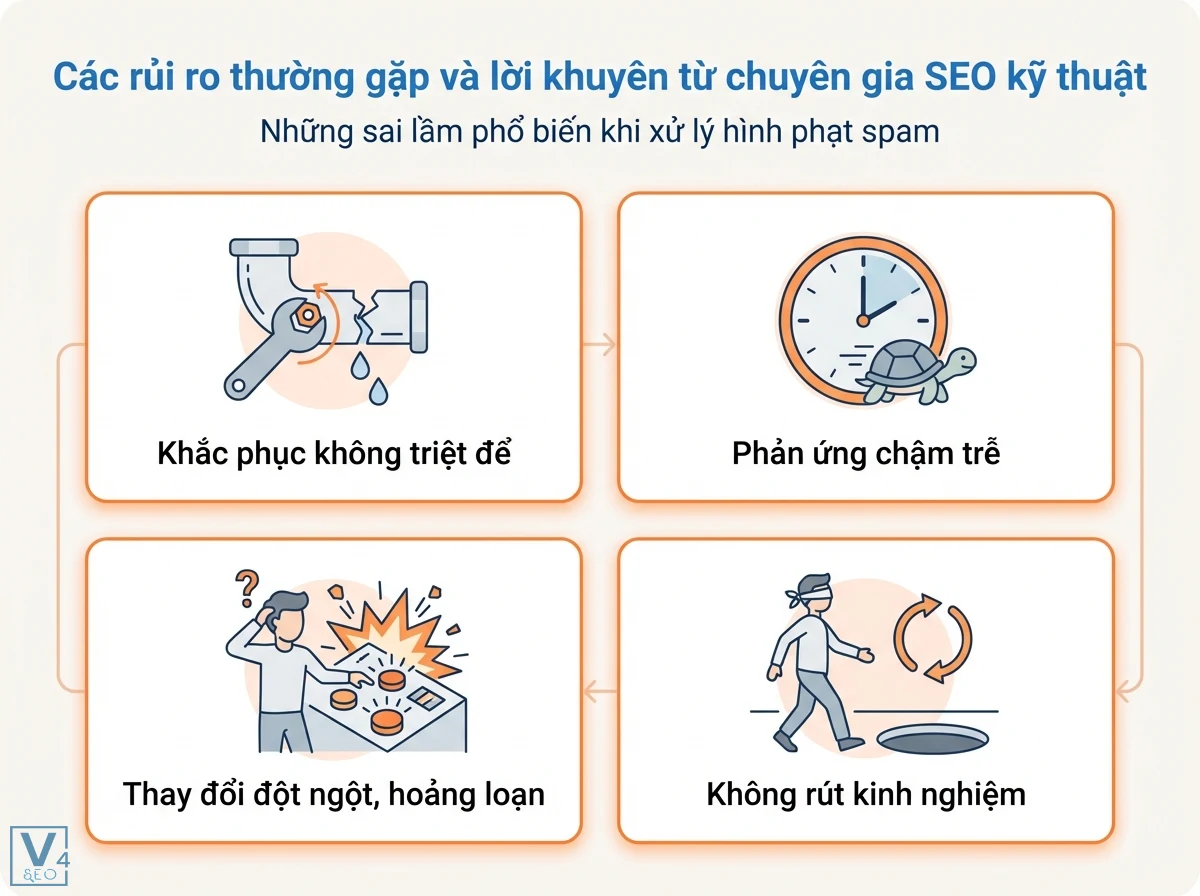

Các rủi ro thường gặp và lời khuyên từ chuyên gia SEO kỹ thuật

Ngay cả những website tuân thủ chặt chẽ vẫn có thể đối mặt với rủi ro hoặc những sai lầm khi xử lý vấn đề spam.

Những sai lầm phổ biến khi xử lý hình phạt spam

1. Không khắc phục triệt để: Nhiều người chỉ khắc phục một phần vấn đề và hy vọng Google sẽ bỏ qua phần còn lại, dẫn đến việc yêu cầu xem xét lại bị từ chối nhiều lần.

2. Phản ứng chậm trễ: Để các vấn đề spam tồn tại quá lâu sẽ gây thiệt hại lớn hơn cho thứ hạng và uy tín.

3. Hoảng loạn và thay đổi lớn đột ngột: Thay vì phân tích kỹ lưỡng, một số website thực hiện các thay đổi lớn không có căn cứ, gây ra các vấn đề mới.

4. Không học hỏi từ sai lầm: Không ghi nhận và đúc kết kinh nghiệm từ các hình phạt để cải thiện quy trình phòng ngừa trong tương lai.

Tầm quan trọng của việc cập nhật kiến thức liên tục

Thế giới SEO luôn thay đổi, với các thuật toán và chính sách của Google được cập nhật liên tục. Để duy trì một website “sạch” và bền vững, việc cập nhật kiến thức thường xuyên là điều bắt buộc. V4SEO khuyến nghị theo dõi các thông báo chính thức từ Google Search Central Blog, các chuyên gia SEO uy tín quốc tế và tham gia vào các cộng đồng chuyên môn để luôn nắm bắt được các xu hướng và quy tắc mới nhất.

Bài viết liên quan

https://v4seowebsite.vn/tu-khoa-chinh-la-gi